Random Variable

•

Random event 의 outcome 을 real scalar value 로 mapping 해주는 함수

•

특정 시행 이전에는 값을 예측할 수 없는 numerical value

•

동전을 던지는 시행 예시

•

Discrete vs. Continuous

◦

Discrete

▪

Discrete Sample Space 를 가짐

▪

Probability Mass Function (PMF)

▪

ex. Binomial Distribution

◦

Continuous

▪

Continuos Sample Space 를 가짐

▪

Probability Density Function (PDF)

•

밑넓이의 합은 1 이어야 함

•

모든 에 대해

▪

ex. Gaussian Distribution

▪

특정 값을 가질 확률 자체는 0, 범위를 가질 확률은 PDF 의 밑넓이

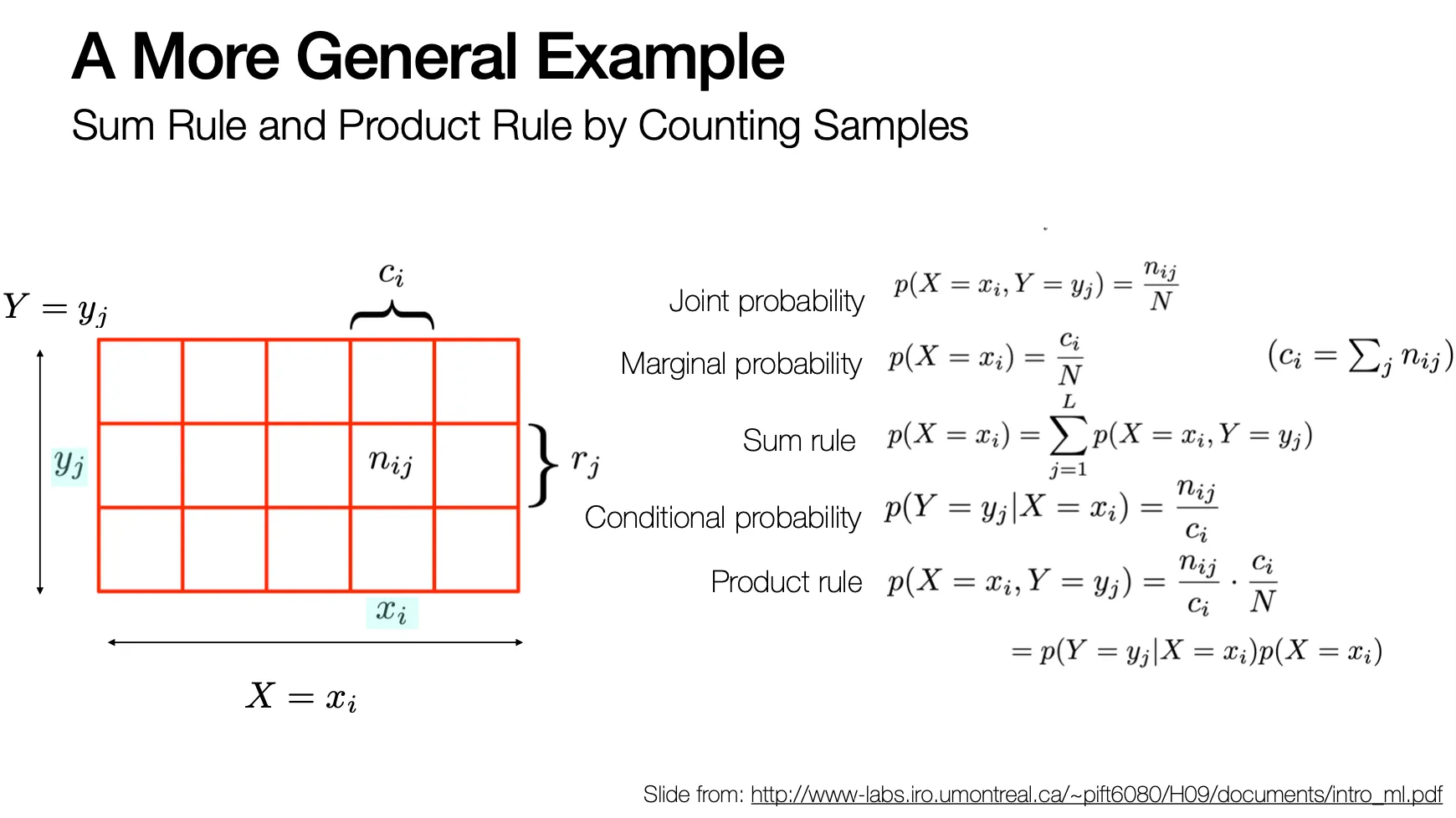

Probability Theory

Bayes’ Theorem

•

Product Rule 과 symmetry property 로 인해 유도됨

Independence in Probability Theory

•

두 event , 가 independent 한 것은 다음과 동치임

•

Bayes’ Theorem 에 의해서 다음도 성립함

Probability Densities with Continuous Random Variables

Expectation

•

기댓값: 특정 값에 해당 값이 나올 확률을 곱해 summation (integral) 한 것

•

Discrete variable

•

Continuous variable

•

Conditional Expectation

Variance

Covariances

•

, 가 vector 인 경우에는 다음과 같이 matrix 형태로 covariance 가 구해짐

Gaussian (Normal) Distribution

•

Multivariate Gaussian 은 다음과 같이 표현됨

Bayesian Probabilities

•

데이터가 나온 분포에 대한 parameter 의 특성에 대한 inference 를 하는 것을 prior 라 함

◦

prior:

•

Obeservation 가 특정 prior 에 의해 나왔을 확률 는 likelihood 라고 함

◦

likelihood:

•

데이터로부터 특정 prior 가 나왔을 확률을 posterior 라고 함

◦

posterior:

•

이고, 는 normalized term 으로 볼 수 있음

Probabilities vs. Likelihoods

•

Probability: 고정된 distribution 의 밑면적

•

Likelihood: 특정 데이터가 변할 수 있는 distribution 에서 나올 수 있는 확률 (-axis value)

Information Theory

•

정보 는 라는 관찰을 통해서 얻을 수 있는 정보의 양을 의미함

•

일반적으로 작을수록 의미있는 정보이기 때문에 가 큼

•

두 독립적인 관찰에 대해서 가 성립함

•

통계적으로 독립인 두 사건 에 대해서

•

위 세 관계를 만족시키기 위해 를 의 형태로 설계함

•

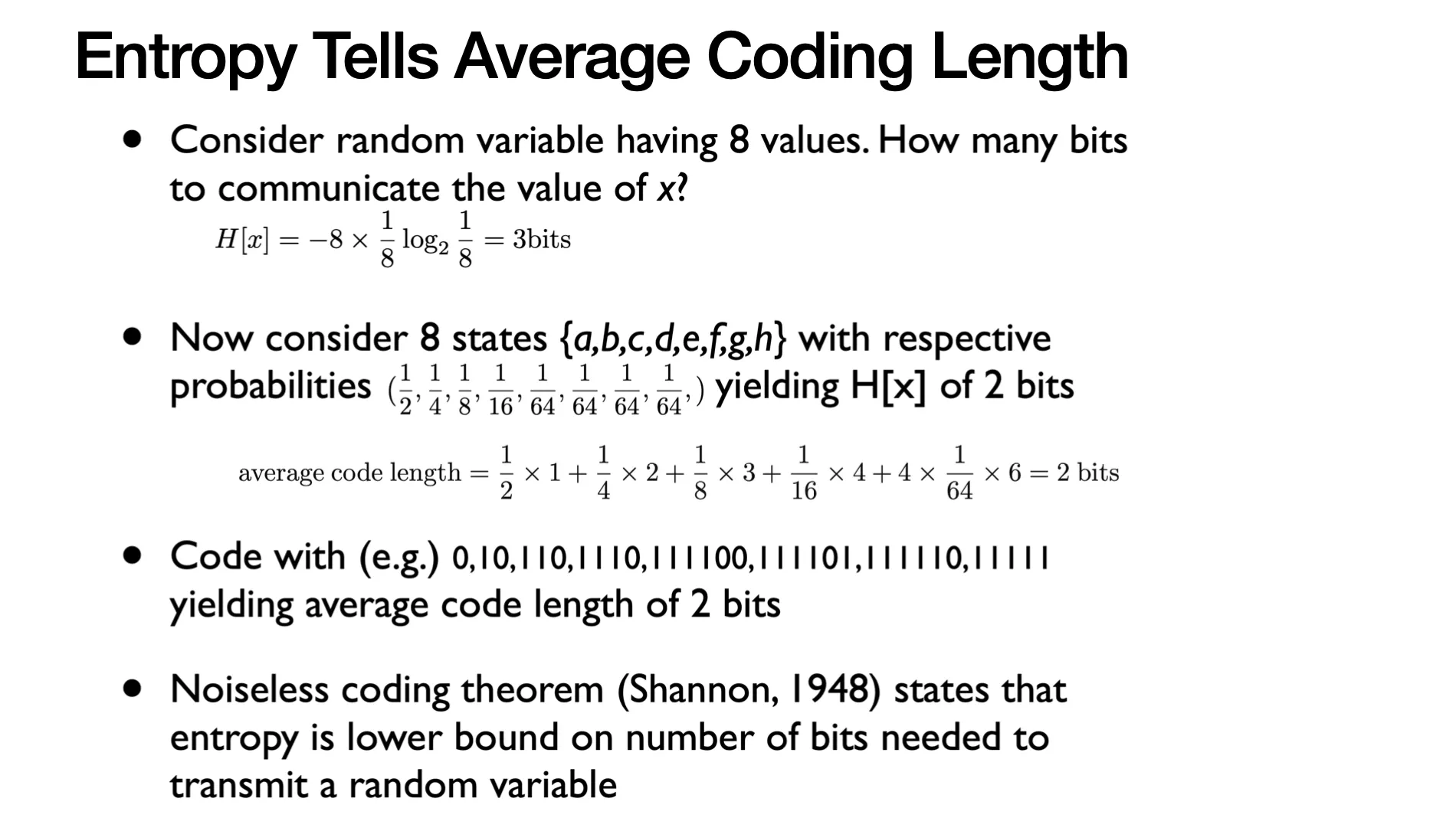

Entropy 는 확률변수 가 전해주는 정보의 총량으로 다음과 같음

◦

Entropy 는 average coding length 를 알려줌 (lower bound on number of bits needed to transmit a random variable) → average 가 가장 작은 encoding 을 사용하는 것이 좋겠죠?!

Kullback-Leibler (KL) Divergence

•

True distribution 대신에 esimation 를 사용했을 때 얻는 추가적인 정보량

•

두 확률분포 와 의 차이를 계산할 수 있는 지표 (추가 정보량이 작으면 분포가 비슷하다는 것임)

•

앞의 항목을 Cross-Entropy 라고 하고 뒤의 항목은 앞서의 의 Entropy 임

•

•

(Jensen’s Inequality 로 증명 가능)

•

•

많은 AI 등에서 모르는 를 로 근사하여 구해냄

Mutual Information

•

두 확률변수 가 얼마나 independent 한지를 측정하는 지표

•

가 independent 하면

•

Mutual Dependence 는 아래와 같이 계산할 수도 있음

◦