Rough Categories of Machine Learning Problems

•

Supervised Learning

◦

Given: Training data + desired outputs (labels)

•

Unsupervised Learning

◦

Given: Training data (without desired outputs)

•

Semi-supervised Learning

◦

Given: Training data + a few desired outputs

Supervised Learning

•

Supervisions (labels) 가 training dataset 에 함께 주어짐

•

Input:

•

Target (label)

•

Regression: 값이 continous, Classification: 값이 discrete

Supervised Learning

•

Regression

◦

Learn to predict from

•

Classification

◦

Learn vector each term represents probability of each categories

Unsupervised (Self-supervise) Learning

•

Clustering: 비슷한 특성을 가진 것들끼리 그룹으로 묶는 task

•

Density Estimation: 데이터 분포를 예측하는 task

•

Dimensionality Reduction and Visulization: 차원 축소 및 시각화 (ex. PCA)

•

Self-supervised Learning

◦

Pretext-task 로 본인만을 이용해서 feature 를 뽑아내고, pre-trained 된 모델에서 target-task 에 knowledge transfer 를 해줌

Training / Testing / Validation Set

•

Training set 과 Testing set 을 분리하는 것은 굉장히 중요함

•

Training set 은 모델을 학습하는데 사용하는 dataset

•

Testing set 은 모델을 평가하는데 사용하는 dataset

•

Validation set 은 Training set 의 일부로 떼어내서 사용할 수 있으며, training 도중에 모델이 얼마나 좋은지 test 해보고 hyper-parameter 를 tuning 할 수 있음!

Supervised Learning: Linear Regressions

•

Example - House Price Estimation

◦

Living Area 와 Bedroom 개수를 바탕으로 집의 가격을 예측!

◦

선택한 모델:

◦

로 두면, 위 식은 로 나타낼 수 있음!

◦

Cost Function: ( 은 편의상 붙임)

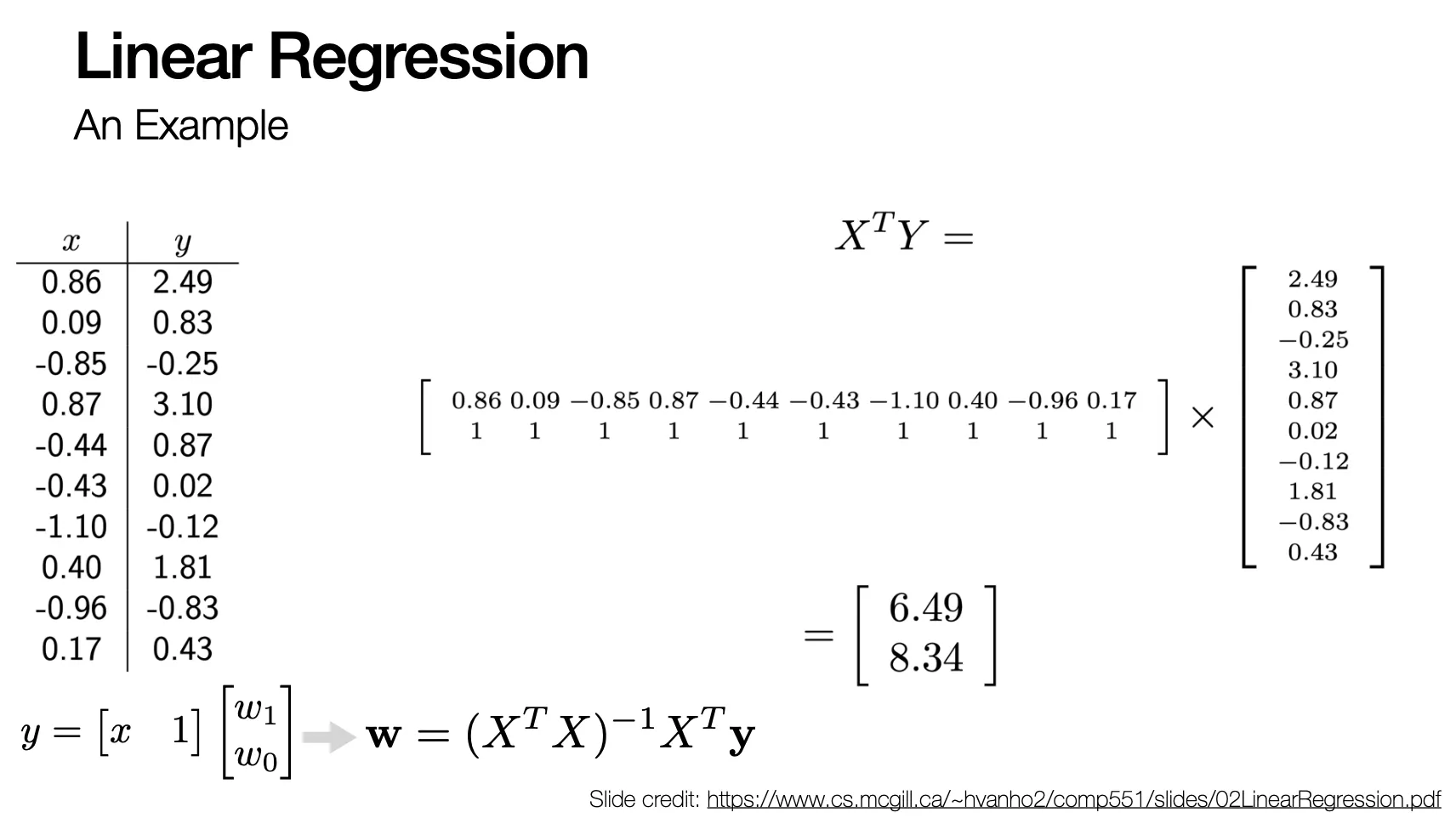

Recall: Least-Squares Problem

•

•

minimize the squared sum of residuals

•

Hyperparameter

◦

이 작으면 underfitting, 이 크면 overfitting

•

이는 곧 를 minimize 하는 문제와 같음

•

Solution 은 다음과 같음 (과정은 미분해서 0 되는 값 찾는 과정으로, 이전에 다룸)

Linear Regressions

•

More expressive power: linear combinations of fixed nonlinear functions

•

◦

•

는 basis function ( 개의 다른 feature)

◦

만으로는 표현력이 부족하기 때문

•

Loss function 은 기존과 동일하게 다음과 같음

◦

이는 곧 를 minimize 하는 것과 같음

◦

Least square 로 마찬가지로 로 구할 수 있음

◦

Gradient descent 로 구할 수도 있음

1-D vs Multi-D

•

의 dimension 은 예측하려는 hyperplane 의 dimension

◦

1 이면 직선, 2 이면 평면

Linear Regression Example

Underfitting vs. Overfitting

•

Underfitting

◦

Model 이 training data 와 test data 모두에서 좋은 결과를 안 보임 (model 이 너무 간단한게 주요 원인)

•

Overfitting

◦

Model 이 training data 는 너무 잘 설명해주지만 unseen data 에 generalize 가 안됨 (model 이 너무 복잡한 것이 주요 원인)

◦

데이터 하나하나의 디테일을 모두 표현하려다 보니 coefficient 의 absolute value 크기가 매우 커짐 → regularization 으로 해결

A Way To Avoid Overfitting

•

Regularization Term

◦

기존 loss 에 더해서 low 를 선호하도록 설정하는 것임

◦

Input 에 상관하지 않음

•

More Generalized Regularization Term

◦

: Lasso, enforcing sparsity

L1 Regularization vs. L2 Regularization

•

L1 Regularizer 가 sparsity 를 더 강조함

◦

Optimize point 가 부드럽게 바뀌지 않고 빠르게 바뀜

•

Classification 의 경우에는 0 아니면 1 로 산출해야 해서 sparsity 가 높고 L1 을 사용할 가능성이 높을 수 있음!

Recall: Random Variable

•

Continuous function 에서의 probability 는 밑면적임

•

특정 데이터가 나올 확률은 0

Linear Regressions: A Probabilistic Perspective

•

Probabilities VS Likelihoods

◦

Probability 는 특정 distribution 으로부터 해당 데이터가 나올 확률

◦

Liklihoods 는 특정 data 가 특정 distribution 에서 나왔을 확률

◦

사실 의미적으로는 동일함

•

Maximum Likelihood

◦

◦

likelihood

◦

log-likelihood

→ multiplication 이 summation 으로 바뀌어서 쉽고, exponential term 이 날아감!

Curve Fitting Re-Visited

•

Curve fitting 의 예측과 실제의 차이를 Gaussian Distribution 이라고 가정하고, MLE 를 돌려보면 결과적으로 동일한 Least square problem 식이 유도됨

◦

Likelihood

◦

Maximum Log Likelihood

→