기본적인 내용은 정리하지 않았습니다. (ex. Vector, Matrix, Matrix Multiplication, etc.)

Hadamard Product (Element-wise Product)

Trace

•

대각 성분의 합

•

•

•

•

where is square

•

where is square

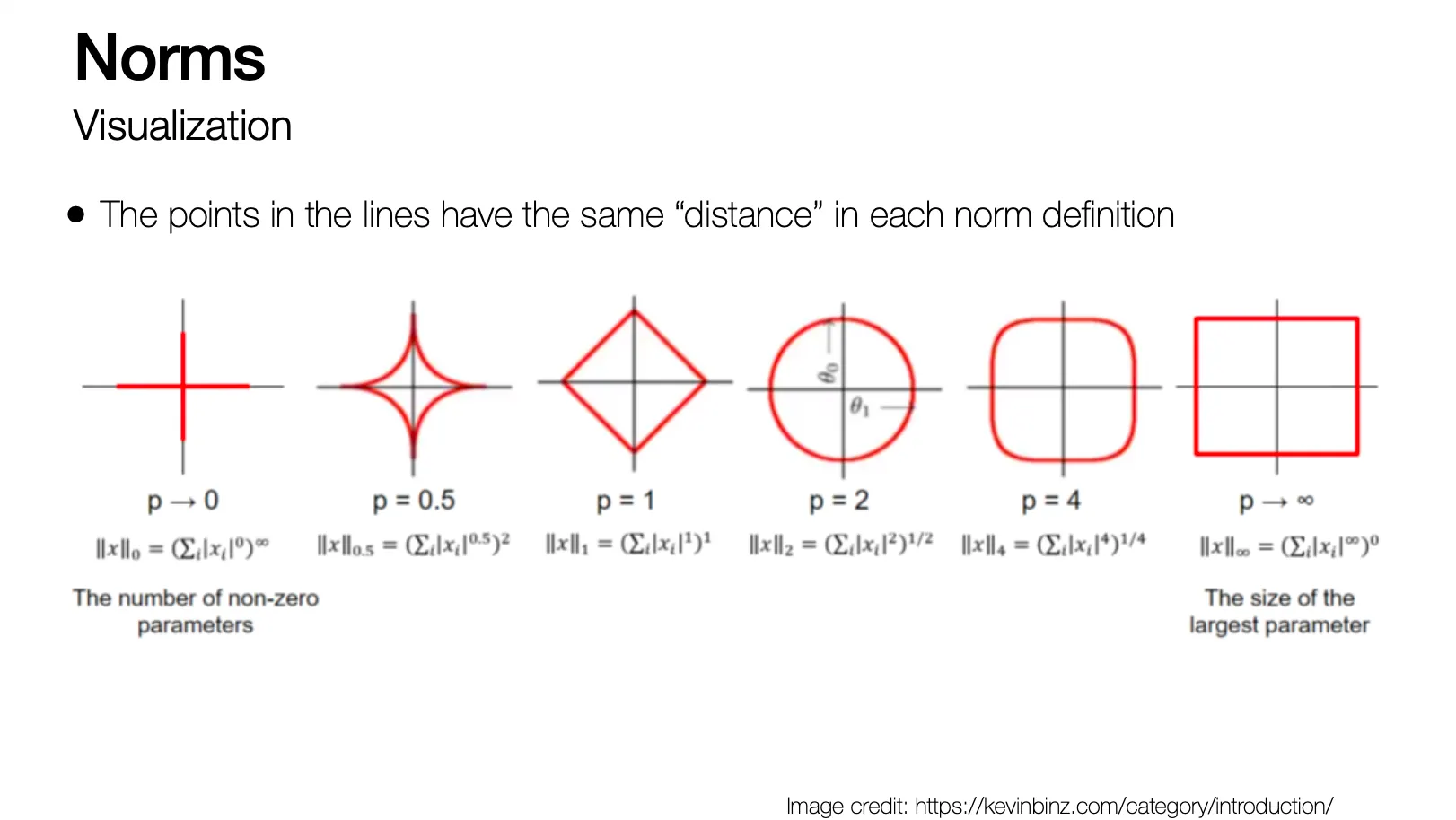

Norms

•

vector 의 각 항을 non-negative 로 변경해주는 함수

•

Intuitive 하게는 origin 으로부터 까지의 거리를 측정하는 함수

•

•

(the triangular inequality)

•

,

•

Norm 의 종류

◦

Euclidean (L2 norm)

◦

L1 norm

◦

L-infinity norm

◦

L0 norm: non-zero element 의 개수

◦

Frobenius norm (matrix norm)

▪

보통 두 matrix 의 similarity 를 계산하는데 사용됨

•

Visualization of Norms

Linear Dependence and Independence

•

Vector 의 set 은 set 내의 어떤 한 벡터를 골라도 나머지 벡터들의 linear combination 으로 표현될 수 없을 때 이 linearly independent 라고 함

Rank of a Matrix

•

Column Rank 는 matrix 의 linearly independent 한 largest column subset 의 크기

•

Row Rank 는 matrix 의 linearly independent 한 largest row subset 의 크기

•

모든 matrix 에 대해서 Row Rank 와 Column Rank 는 동일하고 이를 Rank of , 라고 지칭함

•

에 대해

•

에 대해

•

에 대해

Inverse of a Square Matrix

•

Matrix multiplication 을 행했을 때 Identitiy 가 되는 matrix

•

가 존재하면 를 invertible 혹은 non-singular 라고 함

•

가 존재하기 위해서는 가 full rank 를 가져야 함

•

•

•

Span and Projection

•

Vector set 의 span 은 해당 벡터들의 linear combination 으로 표현할 수 있는 모든 벡터의 set 임

•

Vector 의 span of 에 대한 projection 은 이면서 와의 euclidean norm 이 가장 작은 벡터

Orthogonal Matricies

•

두 벡터 는 이면 orthogonal 하다고 부름

•

벡터 는 이면 normalized 되었다고 부름

•

Square matrix 은 모든 column 이 서로 다른 column 과 orthogonal 일 때 orthogonal 하다고 부름. 각 column 이 normalized 까지 되어있으면 orthonormal 이라고 부름.

•

•

(Orthonormal matrix 와의 matrix multiplication 은 norm 을 유지)

Rotation Matrix

•

은 orthonormal matrix

•